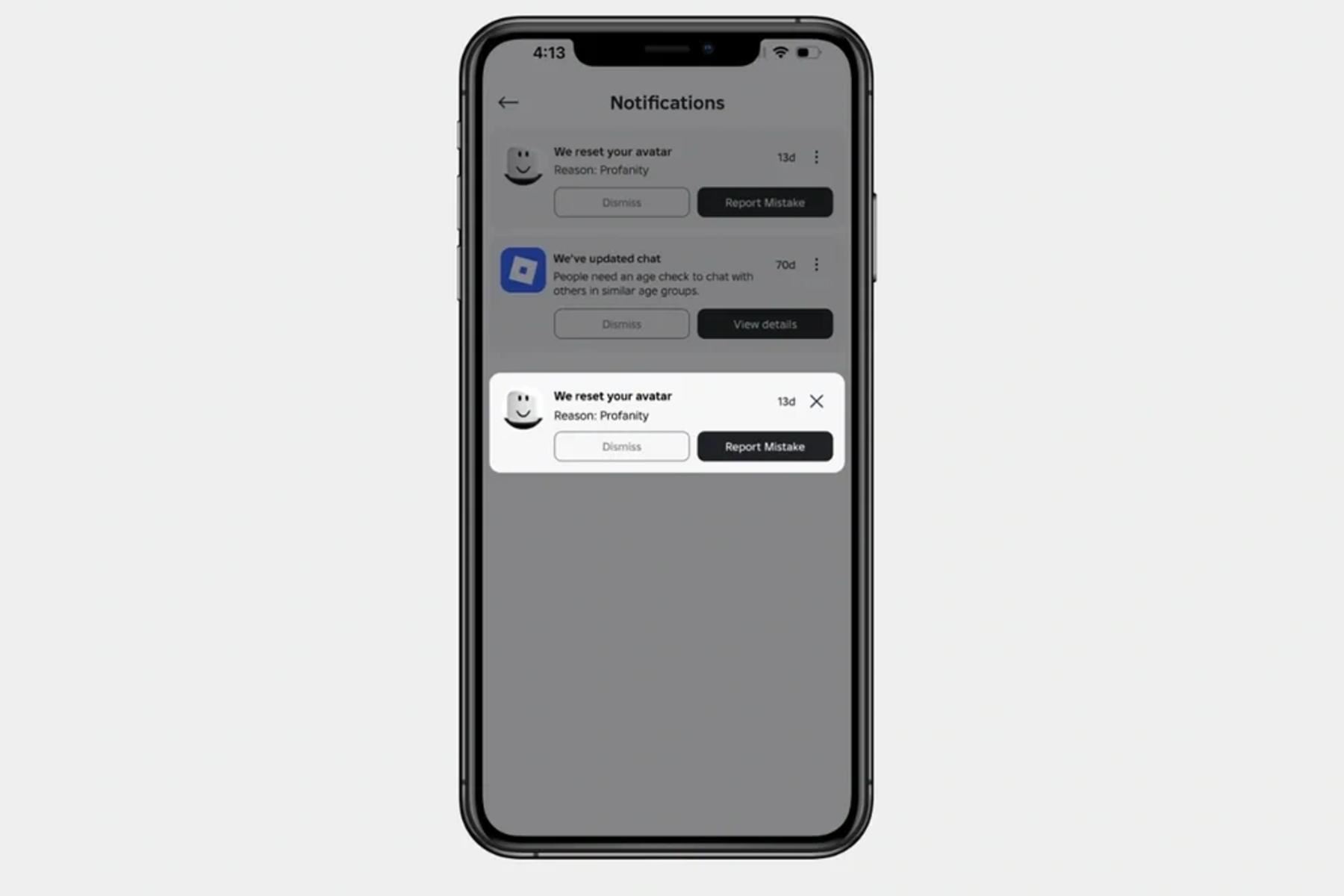

Al restablecer el avatar de un usuario, verá una notificación similar a la anterior, que explica qué política se violó. El avatar se restablece, lo que significa que no tiene ninguna prenda equipada.

La moderación de avatares cobra especial relevancia en una plataforma como Roblox, cuya audiencia está compuesta en gran parte por niños y adolescentes. En los últimos años, diversos reportes y denuncias de usuarios alertaron sobre la presencia de avatares con estéticas sexualizadas o con referencias inapropiadas que, aunque construidas a partir de elementos individuales permitidos, en conjunto generaban representaciones problemáticas.

En 2025, los usuarios realizaron un promedio de 274 millones de actualizaciones de avatar al día en Roblox, lo que representa una enorme cantidad de combinaciones y posibilidad de que se formen atuendos no permitidos. La compañía señaló que, históricamente, solo se detectaban estos casos tras reportes de otros jugadores, lo que demoraba la acción; con este nuevo método la detección es proactiva y en tiempo real.

Desde enero,

Roblox escanea

cada vez que un usuario modifica su avatar, evaluando todos los elementos que tiene equipado (ropa, accesorios y otros ítems) antes de que otros jugadores puedan verlo. Si una combinación de estos elementos viola las políticas de la plataforma,

el avatar se restablece a uno predeterminado y se muestra una notificación explicando qué norma se infringió.

La compañía explica que este cambio busca evitar que los usuarios creen personajes con símbolos, asociaciones o apariencias que infrinjan las normas, incluso si las piezas por separado son consideradas aceptables. El sistema, aunque imperfecto, también permite que los jugadores reporten posibles errores de moderación para su revisión y mejora.

Además de la moderación de avatares, Roblox anunció una alianza con organizaciones como Prosocial Design Network y el Young and Resilient Research Centre de la Western Sydney University, así como con PROJECT ROCKIT, para promover estudios que fortalezcan el comportamiento positivo y las conexiones sociales saludables en espacios digitales. Se han otorgado subvenciones a seis equipos de investigación para avanzar en estos temas.

El informe titulado: "Diseñando para conexiones sociales positivas", expone recomendaciones basadas en evidencia para responsables de políticas y diseñadores tecnológicos que buscan equilibrar la innovación con un entorno seguro para los jóvenes.

Roblox subraya que este tipo de iniciativas (moderación automatizada, colaboración con expertos y educación de los usuarios) son parte de un enfoque de múltiples capas para fomentar entornos digitales donde las personas, especialmente menores, puedan interactuar de forma respetuosa y protegida.

Más en Andina:(FIN) NDP/ LEC/SPV

JRA

Publicado: 16/2/2026